Меня зовут Павел Кондрашов, я главный SEO-менеджер компании i-Media. Мы помогаем предприятиям находить клиентов с помощью поиска и обеспечивать продажи на их веб-сайте. В этой статье я расскажу вам, как я обнаружил неспособность Screaming Frog эмулировать ботов Яндекса. Материал будет полезен как новичкам, так и опытным специалистам.

Слишком много пустых тегов

Исследуя сайт клиента, я обнаружил необычно большое количество пустых тегов заголовков на страницах, которые должны быть закрыты для индексации. Я начал думать, с чем это может быть связано. Подозрение пало на robots.txt.

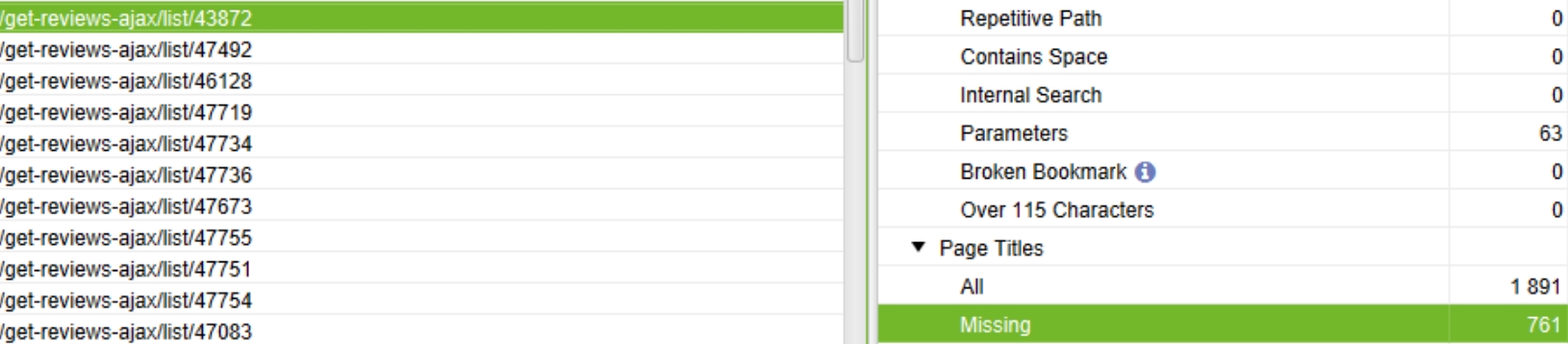

На скриншоте видно, что пустых тегов чуть менее 50%, что в несколько раз превышает норму.

С помощью Вебмастера и служебного файла я проверил, учитывает ли программа нужную директиву. Гипотеза не подтвердилась, файл верный, но проблема не исчезла.

Тогда я предположил, что при разборе файл был проигнорирован в включенной лягушке. Но и здесь все было в порядке.

На скриншоте видно, что программа при анализе учитывает роботов, а это значит, что проблема не в выбранной настройке.

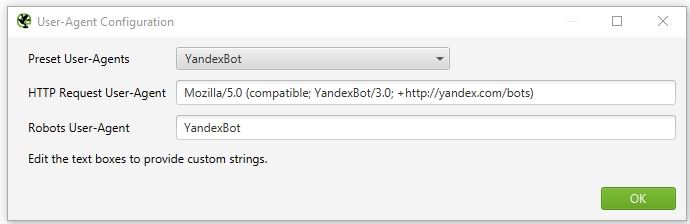

Тогда мне пришла идея: сравнить, какой пользовательский агент в файле robots.txt сайта содержит директиву close и какой пользовательский агент эмулирует Frog. Оказалось, что в robots.txt директива касается только бота user-agent Яндекса и бота Google Screaming Frog. Для проверки гипотезы я сменил бота Google на бота Яндекса, начал сканирование, но страницы остались.

Все оказалось гораздо интереснее

На этом идеи и закончились. Я связался с коллегами, но раньше никто с такой проблемой не сталкивался и они посоветовали мне сделать то, что я уже опробовал и что не сработало. Далее я решил сравнить список ботов, указанный в Справке Яндекса, со списком в Screaming Frog. Они были одинаковыми. Потом я сравнил версии, так как думал, что лягушка не последняя. Но нет.

После некоторого времени размышлений возникла гипотеза о неспособности Screaming Frog эмулировать ботов Яндекса. Это будет означать, что самый популярный и известный инструмент SEO не так универсален.

Пользовательский агент в Справке Яндекса полностью совпал с указанным в Screaming Frog

Для проверки гипотезы я добавил пользовательский файл robots.txt в Screaming Frog. Он содержал директиву, которая блокировала индексацию страницы для всех пользовательских агентов. Все заработало, страницы перестали заходить в Screaming Frog.

И наконец страницы исчезли

Яндекс Бот 1:0 Кричащая Лягушка

Этот случай выявил неспособность Screaming Frog эмулировать ботов Яндекса, а значит, аналитикам и оптимизаторам необходимо внимательно относиться к возможным ограничениям инструментов и проверять полученные данные в Яндекс Мастере. Это единственный способ гарантировать точность результатов и обеспечить эффективные меры по улучшению производительности веб-ресурсов.